Le Règlement pour l’Intelligence Artificielle (RIA ou encore AI Act) a été publié au Journal Officiel de l’Union Européenne ce jeudi 12 juillet 2024. Annoncé en avril 2021 par la Commission Européenne, ce règlement a pour objectif de renforcer la sécurité et les droits fondamentaux des utilisateurs tout en favorisant l'innovation et la confiance dans l'IA.

L'Intelligence Artificielle (IA) transforme rapidement divers secteurs de notre société, allant de la santé à l'éducation, en passant par la finance et les transports (sans oublier le service client). Cependant, cette technologie puissante pose également des défis en matière de sécurité, d'éthique et de droits humains. Pour répondre à ces préoccupations, l'Union Européenne a proposé l'AI Act, un cadre réglementaire visant à garantir un développement et une utilisation sûrs et éthiques de l'IA.

Le RIA, également connu sous le nom d'AI Act, est le premier cadre juridique mondial spécifiquement consacré à la régulation de l'intelligence artificielle. Elle aborde les risques associés à l'IA. L'objectif principal de cette législation est de promouvoir une IA digne de confiance, en garantissant que les systèmes d'IA respectent les droits fondamentaux, la sécurité et les principes éthiques, tout en s'attaquant aux risques posés par des modèles d'IA puissants et influents.

L'AI Act vise à fournir aux développeurs et utilisateurs d'IA des exigences claires et des obligations précises concernant l'utilisation de l'IA. Parallèlement, le règlement cherche à réduire les charges administratives et financières pour les entreprises, notamment les petites et moyennes entreprises (PME). Cette loi fait partie d'un ensemble plus large de mesures politiques, incluant le paquet d'innovation en matière d'IA et le plan coordonné en matière d'IA. Ensemble, ces initiatives visent à assurer la sécurité et les droits fondamentaux des citoyens et des entreprises tout en renforçant l'adoption, l'investissement et l'innovation dans l'IA à travers l'UE.

L'AI Act garantit que les Européens peuvent avoir confiance en l'IA et ses avantages. Alors que la majorité des systèmes d'IA présentent peu ou pas de risques et peuvent contribuer à résoudre de nombreux défis sociétaux, certains systèmes posent des risques significatifs qui doivent être gérés pour éviter des conséquences indésirables.

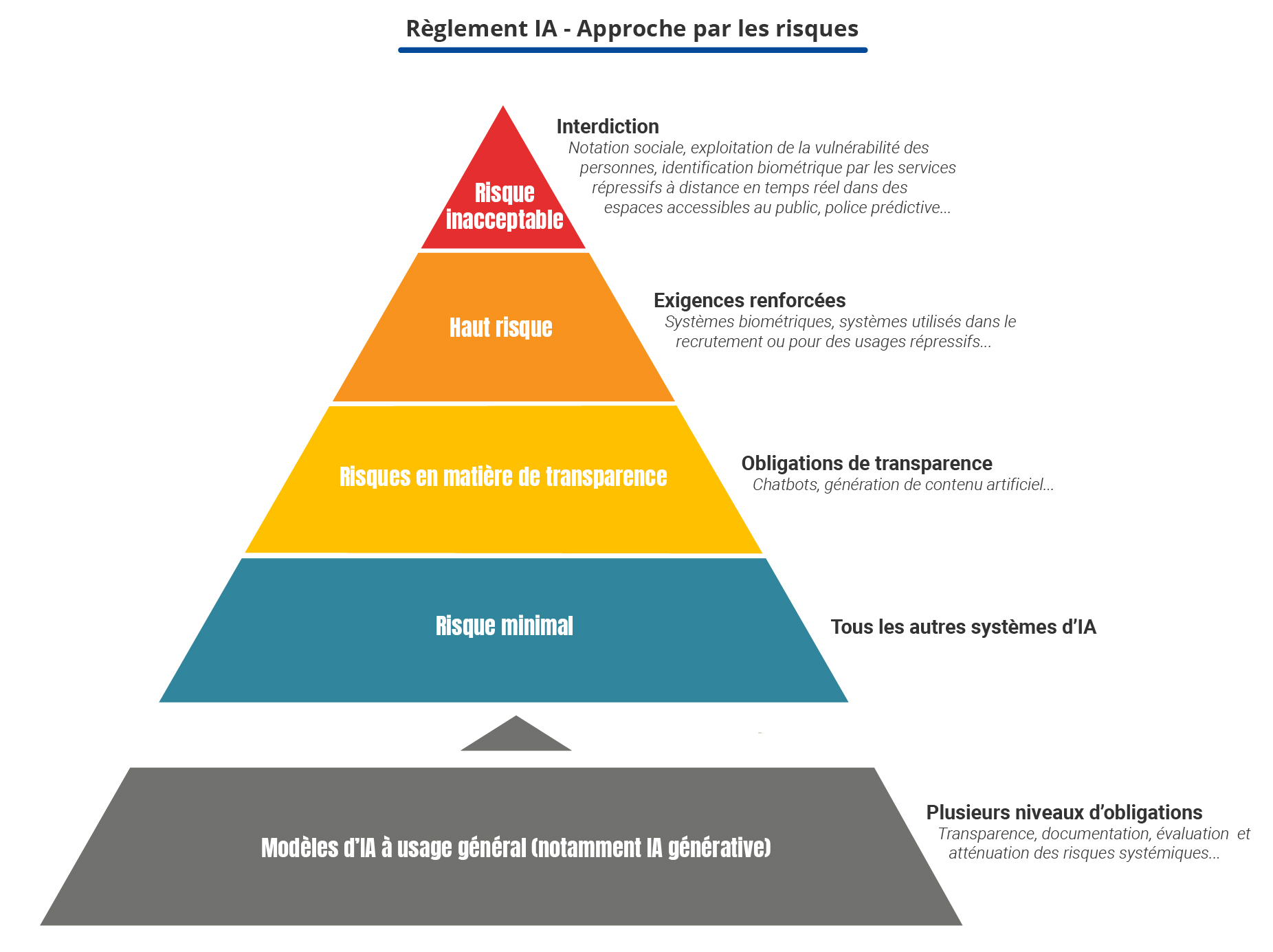

Le RIA propose une approche fondée sur les risques en classant les systèmes d’IA en quatre niveaux :

Certains systèmes d'IA sont interdits car ils posent des menaces évidentes pour la sécurité, les moyens de subsistance et les droits des personnes. Par exemple, les systèmes d'IA qui manipulent le comportement humain pour causer des dommages ou ceux qui exploitent les vulnérabilités des groupes vulnérables (comme les enfants).

Les systèmes d'IA à risque élevé sont ceux pouvant affecter la sécurité des personnes ou leurs droits fondamentaux, justifiant des exigences strictes pour leur développement et déploiement. Les domaines concernés incluent les infrastructures critiques, l'éducation, l'emploi, les services publics essentiels, les forces de l'ordre et la gestion des migrations. Exemples spécifiques :

Les obligations pour ces systèmes incluent :

L'identification biométrique à distance dans les espaces publics est en principe interdite, sauf exceptions strictes (recherche d'un enfant disparu, prévention d'une menace terroriste, etc.), sous autorisation judiciaire et avec des limites appropriées.

Les systèmes d'IA à risque limité sont soumis à des obligations de transparence pour garantir la confiance et la compréhension des utilisateurs. Par exemple, les systèmes d'IA interagissant avec les humains, comme les chatbots, doivent informer les utilisateurs qu'ils communiquent avec une machine, permettant ainsi aux utilisateurs de prendre des décisions éclairées.

Les obligations spécifiques incluent :

Ces mesures visent à renforcer la transparence et à favoriser la confiance du public dans l'utilisation de l'IA.

Pour les systèmes d'IA à risque minimal, l'AI Act n'impose pas de restrictions spécifiques. Ces applications, telles que les jeux vidéo alimentés par l'IA ou les filtres anti-spam, sont largement utilisées sans encadrement strict. Les fournisseurs sont toutefois encouragés à adopter des codes de conduite volontaires pour promouvoir des pratiques responsables.

La majorité des systèmes d'IA actuellement utilisés dans l'UE appartiennent à cette catégorie, permettant une utilisation libre et favorisant l'innovation sans lourdeurs administratives.

Le RIA encadre également les modèles d'IA à usage général, comme les grands modèles de langage (LLM) proposés par des entreprises comme Mistral AI ou OpenAI. Ces modèles, utilisés pour diverses tâches, échappent aux classifications traditionnelles.

Pour ces modèles, le RIA impose plusieurs niveaux d'obligations, allant de la transparence minimale à une évaluation approfondie et des mesures d'atténuation des risques systémiques, tels que les accidents majeurs, les cyberattaques, et les biais discriminatoires.

L'AI Act établit différents niveaux d'exigences en termes de transparence, sécurité et surveillance, principalement basés sur la classification des systèmes d'IA selon leur niveau de risque. Voici un aperçu des principales exigences dans ces domaines :

Les exigences de transparence varient selon le niveau de risque :

Les exigences de sécurité sont particulièrement strictes pour les systèmes à haut risque :

La surveillance humaine est un élément clé de l'AI Act, en particulier pour les systèmes à haut risque :

Il est important de noter que ces exigences sont plus strictes pour les systèmes à haut risque, tandis que les systèmes à risque minimal sont largement exemptés de réglementation spécifique. L'objectif global est de garantir que l'IA soit utilisée de manière sûre, transparente et éthique, tout en favorisant l'innovation dans ce domaine.

Pour comprendre l’impact de cette loi sur le service client, on peut prendre l’exemple des chatbots et assistants virtuels qui sont généralement classés dans les niveaux de risque minimal ou limité. Les entreprises devront :

Si ces systèmes peuvent prendre des décisions significatives, comme des remboursements, ils pourraient être reclassés à un risque élevé. Les entreprises devront alors :

Pour Klark, l'AI Act est à la fois un défi et une opportunité. Nous intégrons déjà les bonnes pratiques RGPD dans nos produits et nous adopterons l'AI Act comme cadre obligatoire pour nos futures fonctionnalités. Notre chatbot respecte les exigences de supervision humaine, offrant une escalade à un humain en cas de besoin, et nous précisons que ce dernier est “powered by Klark”. En anticipant ces contraintes, nous renforçons la confiance des utilisateurs et évitons des modifications coûteuses pour la conformité.

L'AI Act représente une avancée majeure dans la régulation de l'intelligence artificielle en Europe, établissant un cadre clair pour garantir la sécurité, l'éthique et la transparence des systèmes d'IA. En classifiant les systèmes d'IA selon leur niveau de risque, cette législation offre une protection accrue aux utilisateurs tout en stimulant l'innovation et la confiance dans les technologies d'IA.

Pour Klark, l'AI Act est une opportunité de démontrer notre engagement envers des pratiques responsables et transparentes. En intégrant dès le début ces exigences réglementaires dans nos produits, nous renforçons la confiance de nos clients et assurons la conformité de nos solutions d'IA.

En fin de compte, l'AI Act vise à créer un environnement où l'IA peut prospérer en toute sécurité, profitant ainsi à la société dans son ensemble. En adoptant ces nouvelles règles, les entreprises comme Klark peuvent non seulement se conformer à la législation mais aussi mener l'industrie vers un avenir plus éthique et fiable.